Pytorch_模型的保存_加载、并行化、分布式

@TOC

微信公众号:数学建模与人工智能

模型的保存/加载

- torch.saves(state,dir) 保存/序列化

- torch.load(dir) 加载模型

并行化

1 | |

- 获得用于并行化CPU操作的OpenMP线程数

1 | |

- 设定用于并行化CPU操作的OpenMP线程数

分布式

- python在默认情况下只使用一个GPU,再多个GPU的情况下就需要使用pytorch提供的DataParallel

- 单机多卡

- 多机多卡

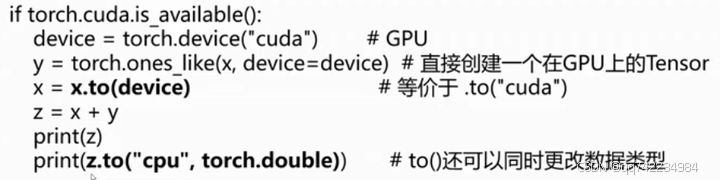

Tensor on GPU

用方法to()可以将Tensor在CPU和GPU(需要硬件支持)之间相互移动

Tensor的相关配置

1 | |

Tensor与numpy的转换

1 | |

Pytorch_模型的保存_加载、并行化、分布式

https://qzkq.github.io/2026/01/02/Pytorch_模型的保存_加载、并行化、分布式/