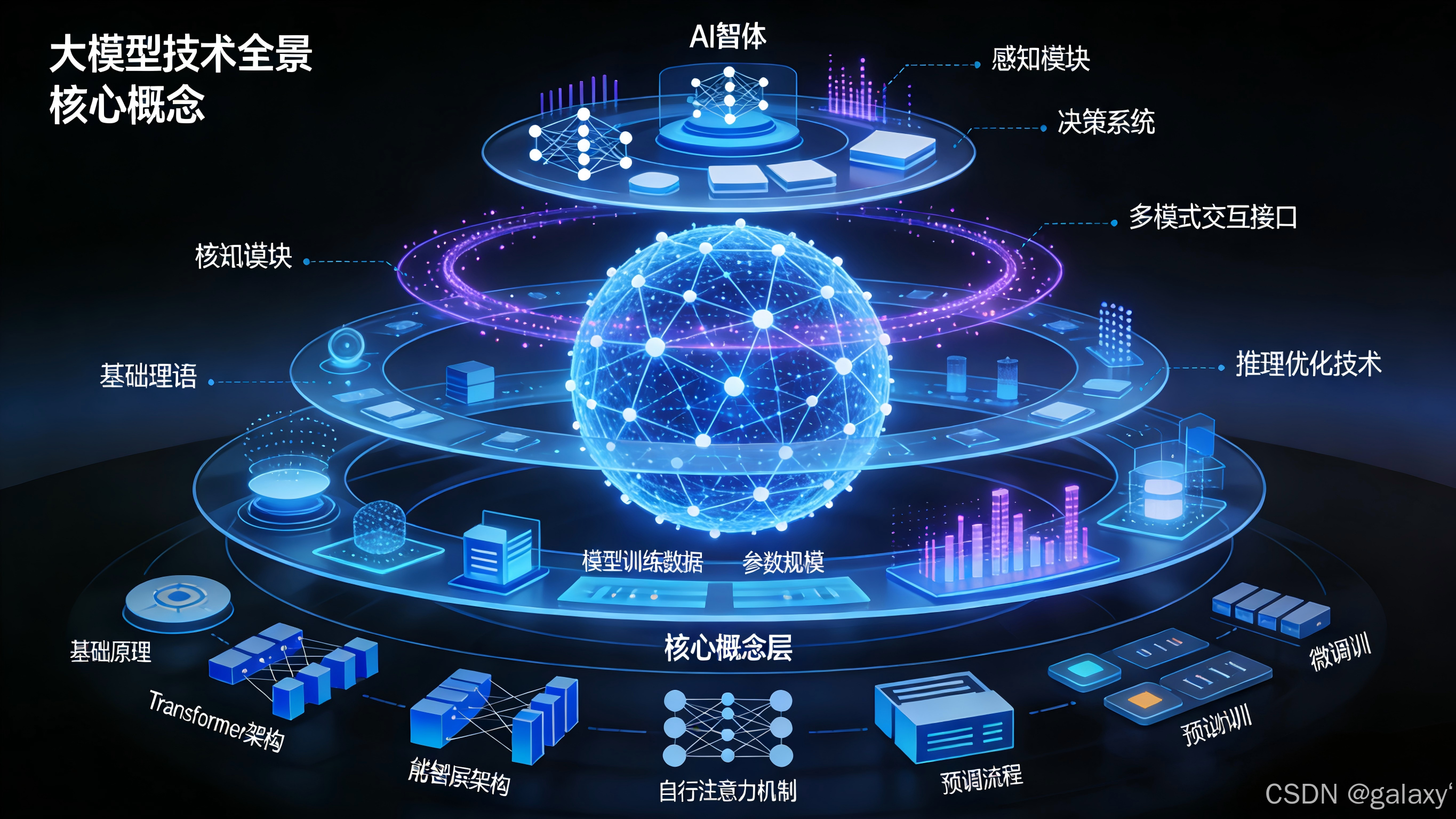

大模型技术全景与核心概念解析:从基础原理到AI智能体架构

@TOC

大模型技术全景与核心概念解析:从基础原理到AI智能体架构

📖 概念索引与要点概览

|| 概念 | 核心定义 | 主要作用与意义 ||

| :————————— | :———————————————————– | :———————————————————– ||

| LLM(大语言模型) | 基于海量文本训练、能理解与生成自然语言的深度学习模型。 | 现代AI语言能力的核心,支撑各类文本生成与理解任务。 ||

| LLMOps | 大语言模型运维,涵盖LLM应用开发、部署、监控与维护的全流程工程实践。 | 确保LLM应用稳定、高效、可靠运行,连接模型研发与实际业务落地。 ||

| AIGC(人工智能生成内容) | 利用AI自动生成文本、图像、音频、视频等内容的技术。 | 推动内容创作自动化,赋能创意产业与数字内容生产。 ||

| AGI(通用人工智能) | 具备与人类相当或超越人类的全面认知能力的AI系统。 | AI研究的长期目标,追求人类级别的通用智能。 ||

| AI智能体(Agent) | 能够感知环境、进行决策并执行动作,以自主完成特定目标的AI系统。 | 将大模型能力转化为自主思考和行动的实体,是AI技术的应用落地方向。 ||

| Prompt(提示词) | 用户输入给模型的指令或问题,用于引导模型生成特定输出。 | 决定模型输出质量与方向的关键输入,是”引导”模型思考的指令。 ||

| Token(标记) | 文本处理的基本单位,由分词器(Tokenizer)将文本拆分而成。 | 模型理解与生成的”语言”单位;API计算与计费的基础。 ||

| B(FLOPs单位) | 十亿次浮点运算,是衡量模型计算复杂度或计算量的常用单位。 | 量化模型推理或训练的”工作量”,是评估算力需求与成本的核心指标。 ||

| LoRA(低秩适应) | 一种高效微调大模型的技术,通过插入低秩矩阵更新部分参数。 | 大幅降低大模型微调成本,使个性化适配更可行。 ||

| 矢量/向量数据库 | 专门用于存储和检索高维向量(如Embedding向量)的数据库。 | 支撑语义搜索、RAG等应用,实现基于内容相似性的高效检索。 ||

| 数据蒸馏 | 从大规模数据或模型中提取核心知识,用于训练更小、更高效的模型。 | 模型压缩与知识迁移的关键技术,平衡性能与效率。 ||

| Embedding(嵌入) | 将文本映射为高维向量的过程,捕捉语义信息。 | 文本的数学表示,使语义计算成为可能。 ||

| MoE(混合专家模型) | 一种稀疏神经网络架构,由多个”专家”子网络和一个”门控网络”组成。 | 以接近小模型的成本,获得媲美超大模型的能力,突破模型规模的瓶颈。 ||

| MCP(模型上下文协议) | 一个标准化的通信协议,用于大模型安全、便捷地调用外部工具和数据源。 | 构建AI智能体的”连接器”与”安全员”,解决工具调用碎片化问题。 ||

| Copilot(辅助编程) | 基于大模型的代码生成与补全工具,如GitHub Copilot。 | 提升开发者效率的AI编程助手,是AI在垂直领域的典型应用。 ||